- · 《语言研究》投稿方式[09/30]

- · 《语言研究》数据库收录[09/30]

- · 《语言研究》栏目设置[09/30]

- · 《语言研究》刊物宗旨[09/30]

- · 《语言研究》征稿要求[09/30]

这项最新调查劝退效果拉满:67% 的 NLPer 怀疑自己(2)

作者:网站采编关键词:

摘要:Q5-2。当前的 NLP 领域过于关注优化基准性能。 Q2-4:到 2030 年,被引用次数最多的五个系统中至少有一个可能会从过去 50 年语言学或认知科学研究结果中汲

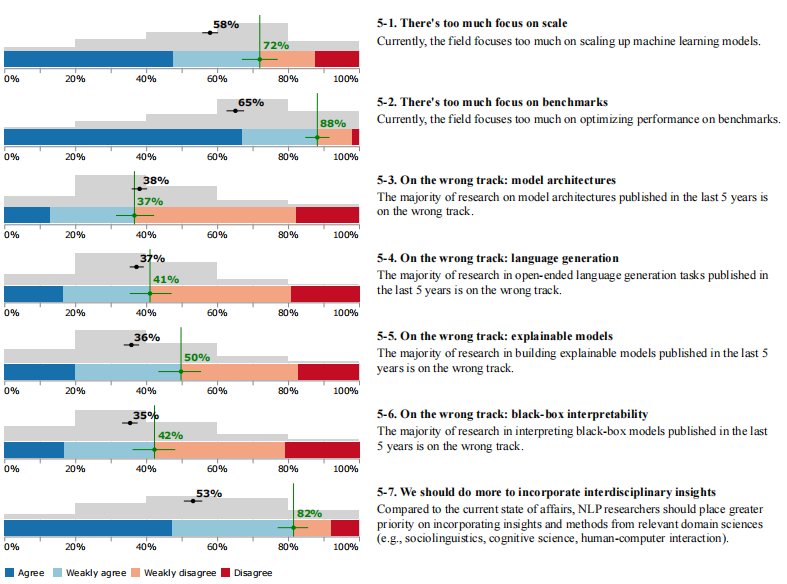

Q5-2。当前的 NLP 领域过于关注优化基准性能。

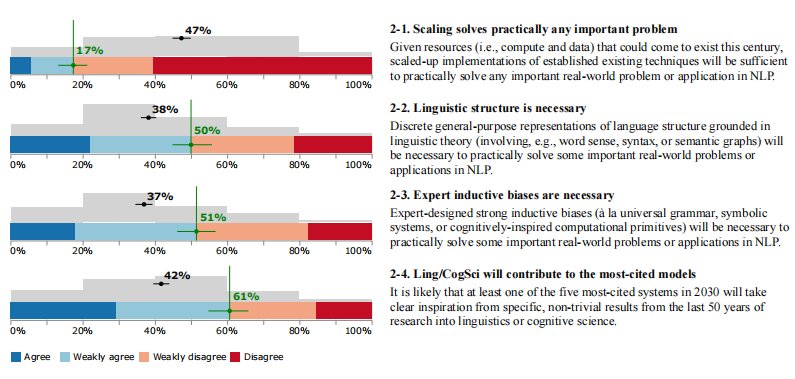

Q2-4:到 2030 年,被引用次数最多的五个系统中至少有一个可能会从过去 50 年语言学或认知科学研究结果中汲取明确的灵感。

此外,大约三分之一(36%) 的人认为,AI 决策可能会导致核战争级别的灾难。这表明,有相当一部分研究者都对 AGI 表示担忧。

另外,受访者的男女比例分别为 67% 和 25%。

NLP 研究人员应该更多考虑整合来自邻近学科(如语言学、认知科学)的见解;

AGI 会带来什么?

ACL 会议的匿名政策比许多其他会议(如 NeurIPS、ICLR 和 ICML)要严格得多。调查表明,尽管争议很多,但 NLP 社区总体上是支持这一政策的, 63% 的人认为匿名可以保证限制预印本的传播)。这个问题也显示出了明显的性别差异,有 77% 的女性表示同意,只有 58% 的男性表示同意。

不过,受访者对这两个问题的回答分歧很大,在学术界人士中,认为工业界的影响力过大的人所占比重为 82 %,而在工业界这一比例为 58%。

最近,一项针对 NLP 社区的调查反映了 NLPer 对所有这些重要问题的看法。来自华盛顿大学、纽约大学和约翰霍普金斯大学的组成的研究团队,就 NLP 领域的一些争议性问题征求了广大研究者的意见,包括研究者在大模型、AGI(通用人工智能)、语言理解、未来方向等多个方面的看法。

NLP 研究人员应该关注 AGI;

Q2-3:专家设计的强归纳偏差(如通用语法、符号系统或受认知启发的计算原语)对于解决一些重要的现实世界问题或 NLP 中的应用是必要的。

有 30 % 的人同意或弱同意寒冬将在未来 10 年内到来,其中仅有 7% 的人选择“同意”;而相信寒冬将在未来 30 年内到来的人要多得多,比例为 62%。

AGI 的争议

与规模化的观点形成对比,受访者对于语言理论、归纳偏差的支持度实际上不低。50% 的人认为,语言结构对于解决 NLP 问题是有必要的;51% 的人认为专家设计的归纳偏差也很重要。许多 NLP 研究者似乎认为,当前使用低归纳偏差的神经网络架构进行端到端建模的趋势将会发生逆转。

NLP 寒冬何时到来?

调查结果真是一看吓一跳,竟有多达 67 % 的 NLP 研究者对自己所从事研究的科学价值抱有怀疑态度!

......

受访者对“可疑”的定义可能是多样的,包括根本不具有完整性的工作、所研究问题不恰当、研究结果无意义,或者研究发现并不重要、不可靠等等。

作者匿名制度的必要性

有?67%?的 NLP 研究者对这一领域研究工作的价值进行了反思,他们认为,大多数 NLP 工作在科学意义上是可疑的。

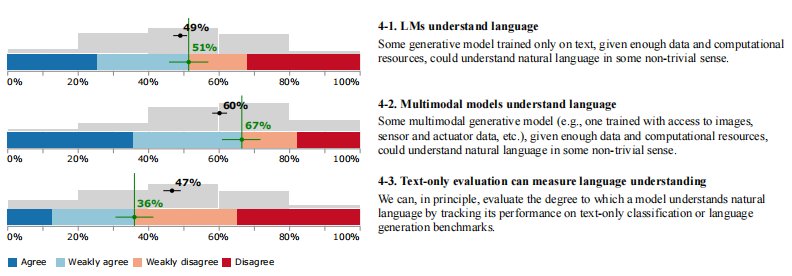

Q4-2:对于多模态生成模型(如一个经过训练可以访问图像、传感器和执行器数据等的模型)而言,只要有足够的数据和计算资源,就可以理解自然语言。

语言模型(LM)是否能理解语言?

Q5-5:过去 5 年发表的构建可解释模型的大多数研究都走错了方向。

在模型架构、语言生成、可解释的模型、黑盒可解释性四个具体的研究方向上,受访的 NLP 研究者对以上问题的同意率分别为 37%、41%、50%、42%,争议较大。在可解释性模型问题上,社区成员的批评态度比较显著。

共有 480 位 NLPer 参与了此次调查。其中 327 人在过去三年中至少发表过两篇 ACL 论文,这部分人是调查的目标人群。

语言理论和归纳偏差的价值

其他受访者同意比例相当高的观点还有:

工业界的领域影响力

分别有 72% 和 88% 的 NLP 研究者认为,现在大家对规模化和优化基准性能的关注过多。

反对最大化规模可以解决一切问题的假设;

Q5-6:过去 5 年发表的大多数可解释黑盒模型的研究都走错了方向。

文章来源:《语言研究》 网址: http://www.yyyjzzs.cn/zonghexinwen/2022/0831/1460.html