- · 《语言研究》栏目设置[09/30]

- · 《语言研究》数据库收录[09/30]

- · 《语言研究》投稿方式[09/30]

- · 《语言研究》征稿要求[09/30]

- · 《语言研究》刊物宗旨[09/30]

ERICA:提升预训练语言模型实体与关系理解的统一(2)

作者:网站采编关键词:

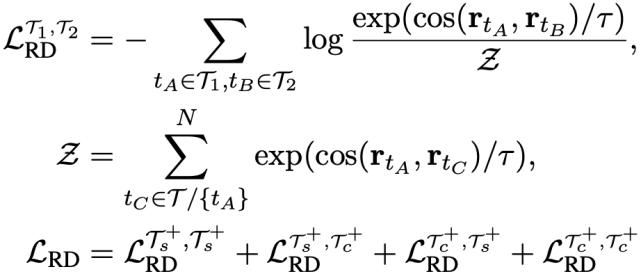

摘要:为了避免灾难性遗忘,作者将上述两个任务同masked language modeling (MLM)任务一起训练,总的训练目标如下所示: 6 实验结果 ERICA的训练不需要引入除了P

为了避免灾难性遗忘,作者将上述两个任务同masked language modeling (MLM)任务一起训练,总的训练目标如下所示:

为了避免灾难性遗忘,作者将上述两个任务同masked language modeling (MLM)任务一起训练,总的训练目标如下所示:

6

实验结果

ERICA的训练不需要引入除了PLM之外的任何参数,并且对于任意模型均能够适配,具体的,作者采用了两个经典的PLM:BERT和RoBERTa,并对其进行一定时间的post-training,最后在文档级关系抽取、实体类别区分、问题回答等任务上进行了测试,并对比了例如CorefBERT, SpanBERT, ERNIE, MTB,CP等基线模型,验证了ERICA框架的有效性。具体结果如下:

a)?文档级关系抽取,模型需要区分文档中的多个实体之间的关系,这需要PLM对实体间关系有较好的理解。

文档级关系抽取(DocRED)

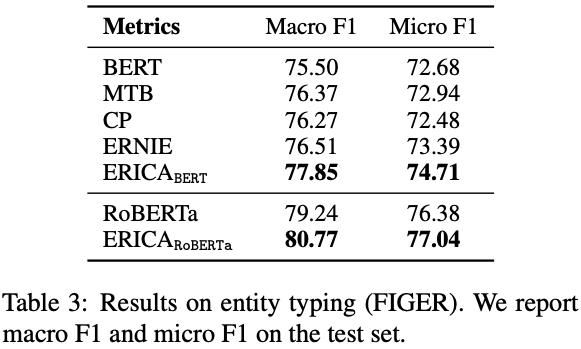

b)?实体类别区分,模型需要区分文本中的实体的具体类别,这需要PLM对实体本身有较好的理解。

实体类别区分(FIGER)

实体类别区分(FIGER)

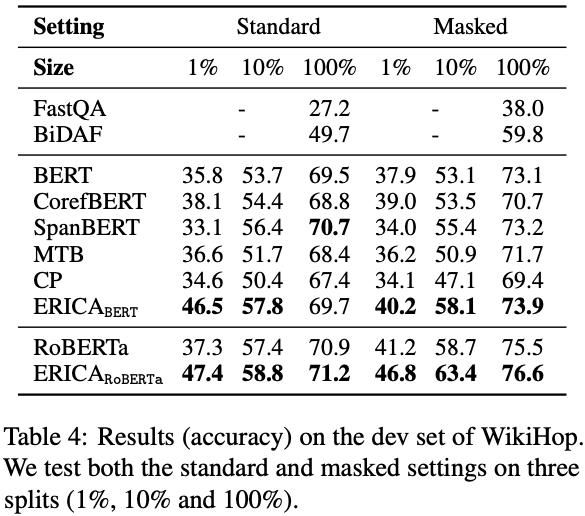

c)?问题回答,作者测试了两种常见的问题回答任务:多选问答(multi-choice QA)和抽取式问答(extractive QA)。这需要PLM对实体和实体间关系有较好的理解。

多选问答(multi-choice QA)

多选问答(multi-choice QA)

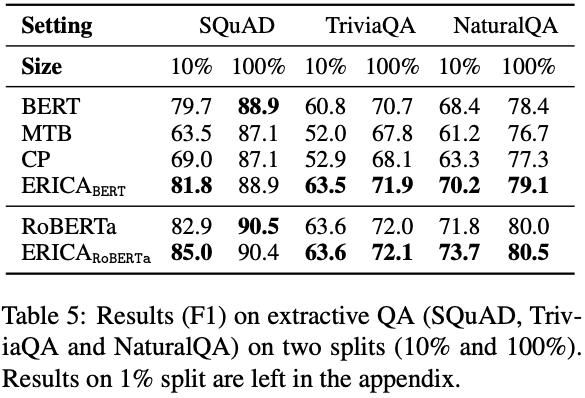

抽取式问答(extractive QA)

抽取式问答(extractive QA)

7

分析

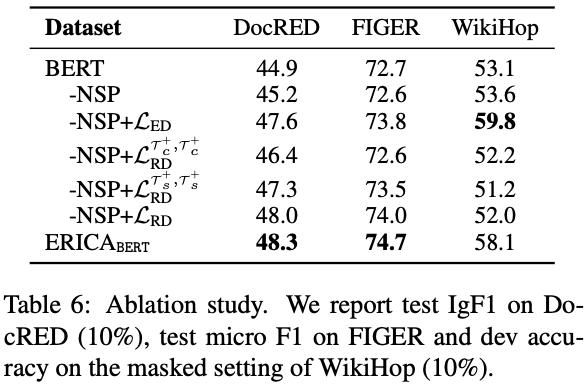

a)?消融分析(ablation study)。作者对ERICA框架中的所有组成成分进行了细致的分析,并证明了这些组成成分对于模型整体效果的提升是缺一不可的。

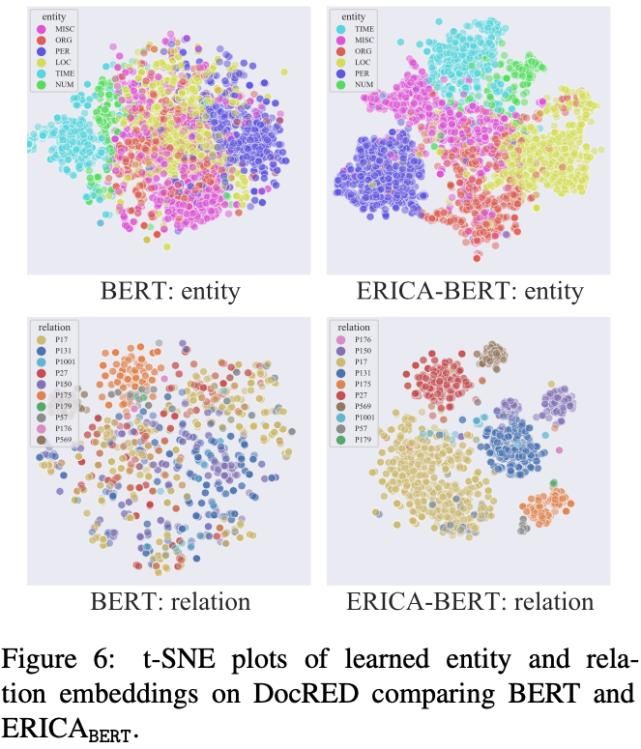

b)?可视化分析。作者对经过ERICA训练前后的PLM对实体和实体间关系的表示进行了可视化,结果如下图所示。通过ERICA的对比学习训练,PLM对于同类别的实体/实体关系的表示有明显的聚类现象,这充分验证了ERICA能够显著增强PLM对实体和实体间关系的理解。

b)?可视化分析。作者对经过ERICA训练前后的PLM对实体和实体间关系的表示进行了可视化,结果如下图所示。通过ERICA的对比学习训练,PLM对于同类别的实体/实体关系的表示有明显的聚类现象,这充分验证了ERICA能够显著增强PLM对实体和实体间关系的理解。

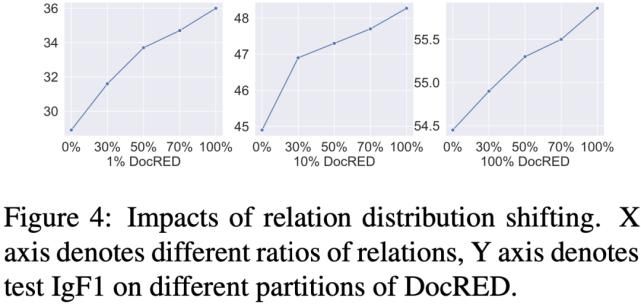

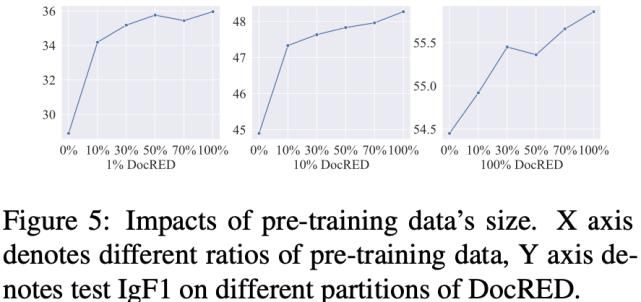

c)?此外,作者分析了远程监督关系的多样性/预训练文档数量对于模型效果的提升。实验结果发现,更加多样的远程监督关系与更大的预训练数据集对于性能的提升有积极的作用。

c)?此外,作者分析了远程监督关系的多样性/预训练文档数量对于模型效果的提升。实验结果发现,更加多样的远程监督关系与更大的预训练数据集对于性能的提升有积极的作用。

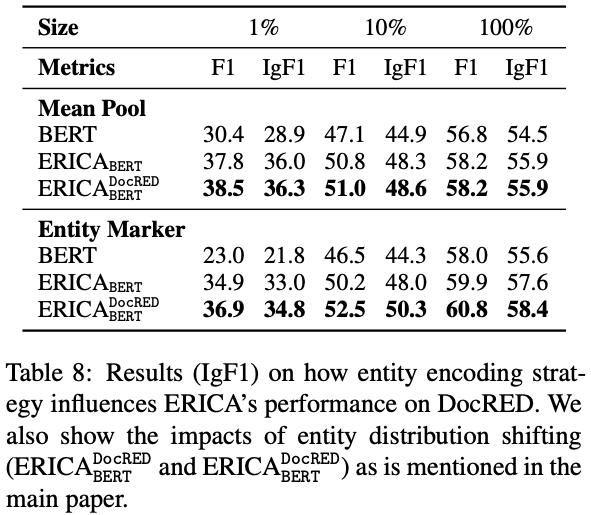

d)?除了使用均匀池化的方式来获得实体/关系表示,作者也尝试使用entity marker的表示方法来测试模型的性能。实验结果证明,ERICA对各种实体/关系表示方法均适用,进一步验证了该架构的通用性。

d)?除了使用均匀池化的方式来获得实体/关系表示,作者也尝试使用entity marker的表示方法来测试模型的性能。实验结果证明,ERICA对各种实体/关系表示方法均适用,进一步验证了该架构的通用性。

8

8

总结

在本文中,作者提出了ERICA框架,通过对比学习帮助PLM提高实体和实体间关系的理解。作者在多个自然语言理解任务上验证了该框架的有效性,包括关系提取、实体类别区分和问题问答。实验结果表明ERICA显著优于所有基线模型,尤其是在低资源的设定下,这意味着 ERICA 可以更好地帮助 PLM捕获文本中的相关事实并综合有关实体及其关系的信息。

由于微信公众号试行乱序推送,您可能不再能准时收到AI科技评论的推送。为了第一时间收到AI科技评论的报道, 请将“AI科技评论”设为星标账号,以及常点文末右下角的“在看”。

文章来源:《语言研究》 网址: http://www.yyyjzzs.cn/zonghexinwen/2021/0616/974.html