- · 《语言研究》栏目设置[09/30]

- · 《语言研究》数据库收录[09/30]

- · 《语言研究》投稿方式[09/30]

- · 《语言研究》征稿要求[09/30]

- · 《语言研究》刊物宗旨[09/30]

ERICA:提升预训练语言模型实体与关系理解的统一

作者:网站采编关键词:

摘要:近年来,预训练语言模型(PLM)在各种下游自然语言处理任务中表现出卓越的性能,受益于预训练阶段的自监督学习目标,PLM 可以有效地捕获文本中的语法和语义,并为下游 NLP 任务提

近年来,预训练语言模型(PLM)在各种下游自然语言处理任务中表现出卓越的性能,受益于预训练阶段的自监督学习目标,PLM 可以有效地捕获文本中的语法和语义,并为下游 NLP 任务提供蕴含丰富信息的语言表示。然而,传统的预训练目标并没有对文本中的关系事实进行建模,而这些关系事实对于文本理解至关重要。

近年来,预训练语言模型(PLM)在各种下游自然语言处理任务中表现出卓越的性能,受益于预训练阶段的自监督学习目标,PLM 可以有效地捕获文本中的语法和语义,并为下游 NLP 任务提供蕴含丰富信息的语言表示。然而,传统的预训练目标并没有对文本中的关系事实进行建模,而这些关系事实对于文本理解至关重要。

具体来说,作者提出了两个辅助性预训练任务来帮助PLM更好地理解实体和实体间关系:

(1)实体区分任务,给定头实体和关系,推断出文本中正确的尾实体;

(2)关系判别任务,区分两个关系在语义上是否接近,这在长文本情景下涉及复杂的关系推理。

实验结果表明,ERICA在不引入额外神经网络参数的前提下,仅仅对PLM进行少量的额外训练,就可以提升典型PLM(例如BERT 和 RoBERTa)在多种自然语言理解任务上(包括关系抽取、实体类别区分、问题回答等)的性能。尤其是在低资源(low-resource)的设定下,性能的提升更加明显。

论文链接: src="http://p2.qhimgs4.com/t01977029a08b6ed182.jpg">传统的预训练目标没有对文本中的关系事实进行显式建模,而这些关系事实对于理解文本至关重要。为了解决这个问题,一些研究人员试图改进 PLM 的架构、预训练任务等,以更好地理解实体之间的关系。

但是它们通常只对文本中的句子级别的单个关系进行建模,不仅忽略了长文本场景下多个实体之间的复杂关系,也忽略了对实体本身的理解,例如图1中所展现的,对于长文本来说,为了让PLM更加充分理解地单个实体,我们需要考虑该实体和其他实体之间的复杂关系;而这些复杂的关系的理解通常涉及复杂的推理链,往往需要综合多个句子的信息得出结论。

针对这两个痛点,本文提出了实体区分任务和关系区分任务来增强PLM对于实体和实体间关系的理解。

2

文档级预训练数据收集

ERICA的训练依赖于大规模文档级远程监督数据,该数据的构造有三个阶段:首先从wikipedia中爬取文本段落,然后用命名实体识别工具(例如spacy)进行实体标注,将所有获得的实体和wikidata中标注的实体对应上,并利用远程监督(distant supervision)信号获得实体之间可能存在的关系,最终保留长度在128到512之间,含有多于4个实体,实体间多于4个远程监督关系的段落。注意这些远程监督的关系中存在大量的噪声,而大规模的预训练可以一定程度上实现降噪。作者也开源了由100万个文档组成的大规模远程监督预训练数据。

3

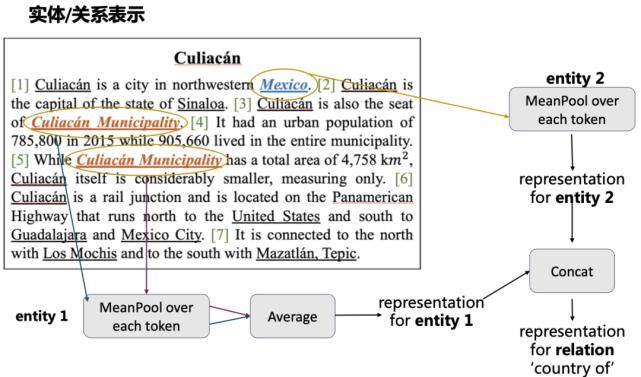

实体与实体间关系的表示

鉴于每个实体可能在段落中出现多次,并且每次出现时对应的描述(mention)可能也不一样,作者在使用PLM对tokenize后的段落进行编码后,取每个描述的所有token均匀池化后的结果作为该描述的表示,接着对于全文中该实体所有的描述进行第二次均匀池化,得到该实体在该文档中的表示;对于两个实体,它们之间的关系表示为两个实体表示的简单拼接。以上是最简单的实体/实体间关系的表示方法,不需要引入额外的神经网络参数。作者在文中还探索了其它的表示方法,并验证了所有方法相比baseline都有一致的提升。

鉴于每个实体可能在段落中出现多次,并且每次出现时对应的描述(mention)可能也不一样,作者在使用PLM对tokenize后的段落进行编码后,取每个描述的所有token均匀池化后的结果作为该描述的表示,接着对于全文中该实体所有的描述进行第二次均匀池化,得到该实体在该文档中的表示;对于两个实体,它们之间的关系表示为两个实体表示的简单拼接。以上是最简单的实体/实体间关系的表示方法,不需要引入额外的神经网络参数。作者在文中还探索了其它的表示方法,并验证了所有方法相比baseline都有一致的提升。

4

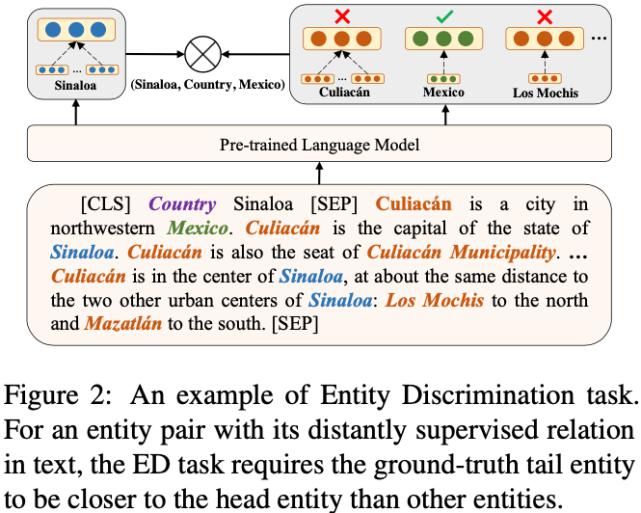

实体区分任务

实体区分任务

实体区分任务

实体区分任务旨在给定头实体和关系,从当前文档中寻找正确的尾实体。例如在上图中,Sinaloa和Mexico具有country的远程关系,于是作者将关系country和头实体Sinaloa拼接在原文档的前面作为提示(prompt),在此条件下区分正确的尾实体的任务可以在对比学习的框架下转换成拉近头实体和正确尾实体的实体表示的距离,推远头实体和文档中其它实体(负样本)的实体表示的距离,具体的公式如下所示:

5

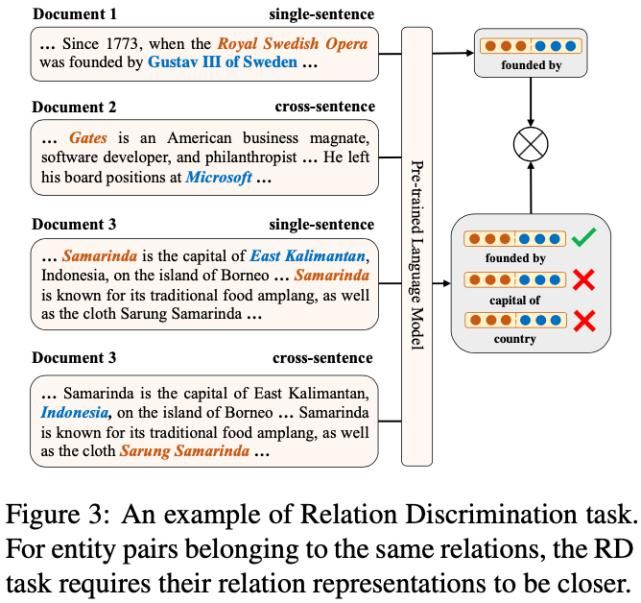

关系区分任务

关系区分任务

关系区分任务

关系区分任务旨在区分两个关系的表示在语义空间上的相近程度。由于作者采用文档级而非句子级的远程监督,文档中的关系区分涉及复杂的推理链。具体而言,作者随机采样多个文档,并从每个文档中得到多个关系表示,这些关系可能只涉及句子级别的推理,也可能涉及跨句子的复杂推理。之后基于对比学习框架,根据远程监督的标签在关系空间中对不同的关系表示进行训练,如前文所述,每个关系表示均由文档中的两个实体表示构成。正样本即具有相同远程监督标签的关系表示,负样本与此相反。作者在实验中还发现进一步引入不具有远程监督关系的实体对作为负样本可以进一步提升模型效果。由于进行对比训练的两个关系表示可能来自于多个文档,也可能来自于单个文档,因此文档间/跨文档的关系表示交互都得到了实现。巧妙的是,对于涉及复杂推理的关系,该方法不需要显示地构建推理链,而是“强迫”模型理解这些关系并在顶层的关系语义空间中区分这些关系。具体的公式如下所示:

文章来源:《语言研究》 网址: http://www.yyyjzzs.cn/zonghexinwen/2021/0616/974.html